AMD и Qualcomm готовят собственные SOCAMM‑модули памяти для ИИ‑серверов

AMD и Qualcomm вслед за Nvidia планируют использовать модульную память стандарта SOCAMM в будущих платформах для серверов искусственного интеллекта. По данным южнокорейских источников, обе компании уже работают над собственными вариантами SOCAMM‑модулей, нацеленными на устранение дефицита ёмкости памяти в системах для генеративного и автономного ИИ.

SOCAMM (Small Outline Compression Attached Memory Module) и его развитие SOCAMM2 основаны на энергоэффективной LPDDR5X и изначально создавались при участии Nvidia. В отличие от распаянной LPDDR и дорогих стеков HBM, SOCAMM представляет собой сменный и масштабируемый модуль, который может дополнять HBM, обеспечивая терабайты оперативной памяти для языковых моделей и агентных ИИ‑систем. SOCAMM2 уже стандартизирован JEDEC и выпускается Samsung и Micron в емкостях до 192 ГБ, обеспечивая до 9600 МТ/с при вдвое большей пропускной способности по сравнению с DDR5 и на 55% меньшем энергопотреблении.

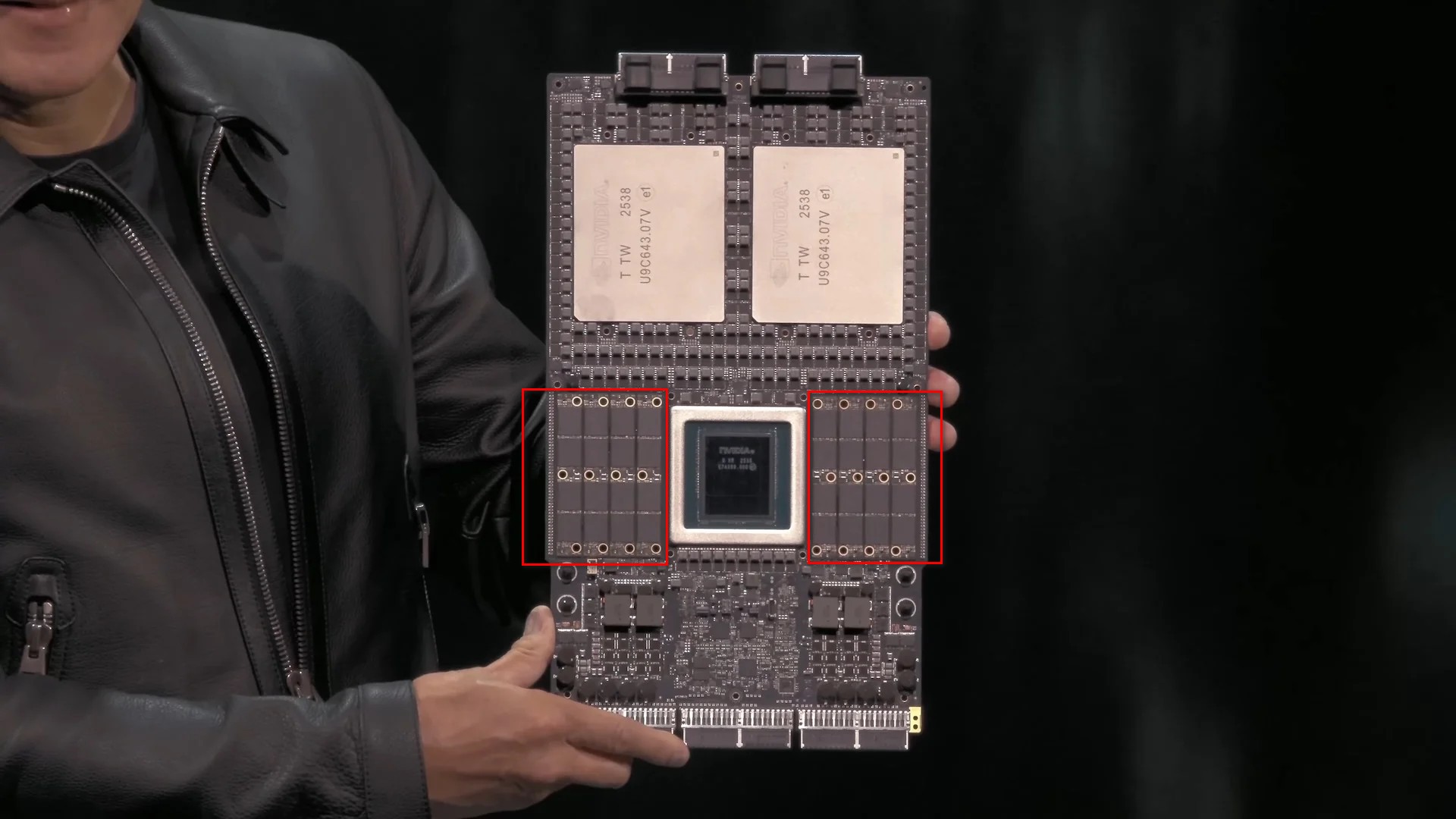

Если Nvidia в платформе Vera Rubin использует вытянутые узкие модули SOCAMM2, то AMD и Qualcomm изучают иную компоновку. Речь идёт о примерно квадратном модуле с четырьмя чипами DRAM, расположенными сеткой 2×2. Ключевое отличие — интеграция схемы управления питанием (PMIC) непосредственно на модуль памяти, а не на системную плату.

Перенос PMIC на сам SOCAMM‑модуль упрощает разводку и снижает сложность материнских плат, одновременно улучшая стабильность работы памяти на экстремальных частотах: регулировка напряжения происходит в непосредственной близости от чипов DRAM. Для дата‑центров это означает более высокую плотность ОЗУ, лучшую энергоэффективность и потенциальное снижение стоимости серверных платформ для ИИ. Если к SOCAMM‑подходу присоединятся и другие игроки, спрос на DRAM для ИИ‑серверов может вырасти ещё сильнее, а конкуренция с доминирующей сегодня Nvidia сместится из области «сырых» вычислений в зону архитектуры и эффективности подсистемы памяти.