Nvidia анонсировала Rubin CPX — GPU для ИИ-моделей с контекстом до миллиона токенов

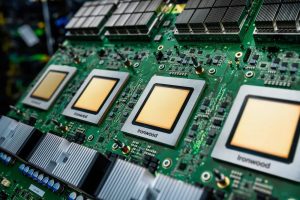

Компания Nvidia представила специализированный графический процессор Rubin CPX, спроектированный для нейросетей, которым требуется удерживать в памяти экстремально длинный контекст — до миллиона токенов и более. Новинка обеспечивает до 30 петафлопс вычислительной мощности в формате NVFP4 и оснащена 128 ГБ оперативной памяти GDDR7, что позволяет обойтись без дорогостоящей HBM и одновременно ускорить операции «внимания» втрое по сравнению с решениями поколения GB300 NVL72.

Rubin CPX входит в новую архитектуру Rubin и работает в тандеме с обычными Rubin GPU по схеме distributed output: специализированный чип формирует контекст, а классический GPU отвечает за генерацию. В таком распределении ресурсов Nvidia видит ключ к масштабированию: в составе стойки Vera Rubin NVL144 CPX, где трудятся 144 Rubin CPX и 144 Rubin GPU, совокупная производительность достигает 8 эксафлопс, а объём быстрой памяти — 100 ТБ. Это примерно в 7,5 раза превышает показатели предыдущего поколения кластеров компании.

Ориентация на длинный контекст открывает чипу широкий спектр применений: от генерации видеоконтента и анализа многотомных юридических документов до автоматизации программирования, где важно одновременно учитывать сотни тысяч строк кода. Встроенные блоки NVENC/NVDEC ускоряют кодирование и декодирование видео, что дополнительно повышает эффективность при работе с мультимедийными данными.

Nvidia подчёркивает и экономическую сторону вопроса: по расчётам компании, каждый вложенный в инфраструктуру Rubin CPX $100 млн способен принести до $5 млрд выручки за счёт роста спроса на модели искусственного интеллекта следующего поколения. Первые поставки GPU Rubin CPX и стоек Vera Rubin NVL144 CPX намечены на конец 2026 года, а крупные исследовательские центры и коммерческие заказчики уже планируют интеграцию нового железа в свои дата-центры.

Таким образом, Rubin CPX становится для Nvidia очередной попыткой задать рынок: миллион токенов контекста, 30 петафлопс на кристалл и 8 эксафлопс на стойку обещают вывести обучение и инференс ИИ-моделей на принципиально иной уровень производительности и масштабируемости.